4 Révélations sur la Puce Rubin de Nvidia qui Redéfinissent l’Avenir de l’IA

Plus qu’une simple mise à jour, un changement de paradigme

Au rythme effréné de l’innovation en intelligence artificielle, chaque annonce matérielle promet des avancées. Cependant, la récente confirmation de Nvidia est d’une autre nature. Loin d’être une simple présentation conceptuelle, la plateforme Vera Rubin (R100) est déjà entrée en phase de production massive et sera disponible pour les partenaires cloud dès le second semestre 2026. Il ne s’agit pas d’une amélioration, mais d’une refonte complète de l’infrastructure sur laquelle reposera la prochaine décennie de l’IA. Cet article décortique les 4 révélations les plus impactantes de cette nouvelle architecture.

1. L’Adieu au « Mur de la Mémoire » : Une Efficacité Multipliée par 5

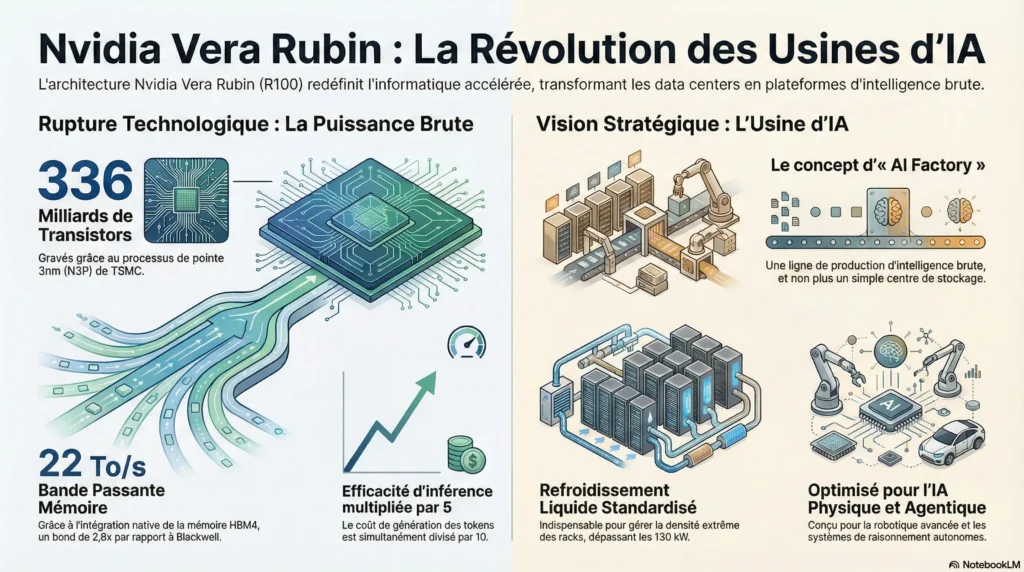

La plus grande avancée de la plateforme Rubin n’est pas seulement sa puissance brute, mais une efficacité radicalement améliorée qui résout un goulot d’étranglement historique. Ce bond en avant est rendu possible par une ingénierie de pointe : gravée sur le nœud 3nm (N3P) de TSMC, la puce intègre un nombre colossal de 336 milliards de transistors.

Cette densité permet des innovations architecturales majeures. Le GPU Rubin intègre nativement la mémoire HBM4, offrant une bande passante phénoménale de 22 To/s, soit 2,8 fois celle de son prédécesseur, Blackwell. Cette capacité brise le mur de la mémoire pour les modèles de langage géants. Parallèlement, le nouveau processeur Vera CPU, avec son cœur « Olympus » (ARM v9.2), double les performances de traitement de données par rapport à la génération Grace.

Le résultat est une performance sans précédent : Nvidia revendique 50 PFLOPS en inférence (NVFP4), se traduisant par une multiplication par 5 de l’efficacité par rapport à Blackwell et une réduction par 10 du coût de génération des tokens. C’est ce qui rend le déploiement d’IA extrêmement puissantes économiquement viable à grande échelle.

2. Du Data Center à l’« Usine d’IA » : La Production d’Intelligence Brute

Avec Rubin, Nvidia redéfinit la nature même du data center en introduisant le concept stratégique d’« AI Factory » (Usine d’IA). Cette vision transforme fondamentalement la mission de ces infrastructures.

l’usine d’IA est une ligne de production d’intelligence brute.

Contrairement aux centres de données traditionnels conçus pour le stockage, l’usine d’IA est optimisée pour la production active et continue d’intelligence. Cette transformation est rendue possible par une intégration verticale complète au sein du rack NVL72. Grâce au commutateur NVLink 6 (offrant 3,6 To/s de bande passante) et au DPU BlueField-4 (cadencé à 800 Gb/s), le rack cesse d’être une collection de serveurs pour devenir une entité de calcul unique et cohérente. Pour gérer les densités de puissance extrêmes, dépassant les 130 kW par rack, la standardisation du refroidissement liquide direct devient une nécessité absolue.

3. L’IA devient Physique et Autonome : Au-delà des Chatbots

L’architecture Rubin et le concept d’Usine d’IA ne sont pas une fin en soi ; ils sont conçus pour fabriquer la prochaine génération d’intelligence artificielle. Ce sont les « produits » qui sortent de cette ligne de production qui révèlent la véritable ambition de Nvidia, bien au-delà des chatbots :

- IA Agentique : des systèmes autonomes capables de mener des raisonnements complexes et de prendre des décisions pour accomplir des tâches, constituant l’intelligence logicielle de demain.

- IA Physique : la robotique industrielle avancée, un domaine où Nvidia concrétise sa vision à travers son partenariat stratégique avec Siemens pour créer les usines du futur.

Ce positionnement est crucial : il signale le passage stratégique de l’IA d’un monde purement numérique à une interaction concrète et productive avec le monde physique.

4. La Nouvelle Règle du Jeu : Une Cadence Annuelle pour Verrouiller le Marché

Au-delà de la technologie, la stratégie commerciale de Nvidia change radicalement les règles du jeu. L’entreprise officialise son passage à un cycle d’innovation annuel pour ses plateformes d’IA. Cette cadence agressive force les concurrents, comme AMD avec sa série MI400 et Intel avec Jaguar Shores, à s’engager dans une course effrénée où tout retard se paie par une marginalisation quasi-immédiate. En ne laissant aucun répit au marché, Nvidia empêche l’émergence d’alternatives viables.

L’objectif stratégique est clair : en réduisant drastiquement le coût marginal de l’intelligence, l’entreprise vise à s’assurer que sa plateforme intégrée reste le standard de facto de l’informatique accélérée pour la prochaine décennie, reléguant ses rivaux à des marchés de niche.

Conclusion : L’Économie de l’Intelligence selon Nvidia

La plateforme Rubin démontre que Nvidia ne vend plus seulement des puces, mais construit l’intégralité de l’écosystème pour une nouvelle économie basée sur la production d’intelligence artificielle. En maîtrisant à la fois le matériel, le logiciel et la cadence d’innovation, l’entreprise dessine les contours du futur industriel. La question n’est plus de savoir si l’IA va tout changer, mais à quelle vitesse et selon les règles de qui ?

Share this content:

Laisser un commentaire