Une IA de Google recommande un sextoy pour une thérapie d’enfant : les dérapages de l’intelligence artificielle

L’intelligence artificielle (IA) de recherche de Google se trouve au cœur d’une polémique inquiétante. Imaginez une technologie capable de confondre un outil thérapeutique pour enfants avec un sextoy. Cet événement, qui a pris de l’ampleur sur Reddit, met en lumière les failles criantes des systèmes d’IA lorsqu’il s’agit de traiter des informations complexes.

Une recherche anodine, une recommandation troublante

Un utilisateur de Reddit a effectué une recherche sur « grossesse baguette magique » et a été confronté à une suggestion choquante. L’IA de Google proposait le « Magic Wand » d’Hitachi, un sextoy bien connu, comme outil thérapeutique pour les enfants. Cette recommandation alarmante a suscité de vives réactions en ligne.

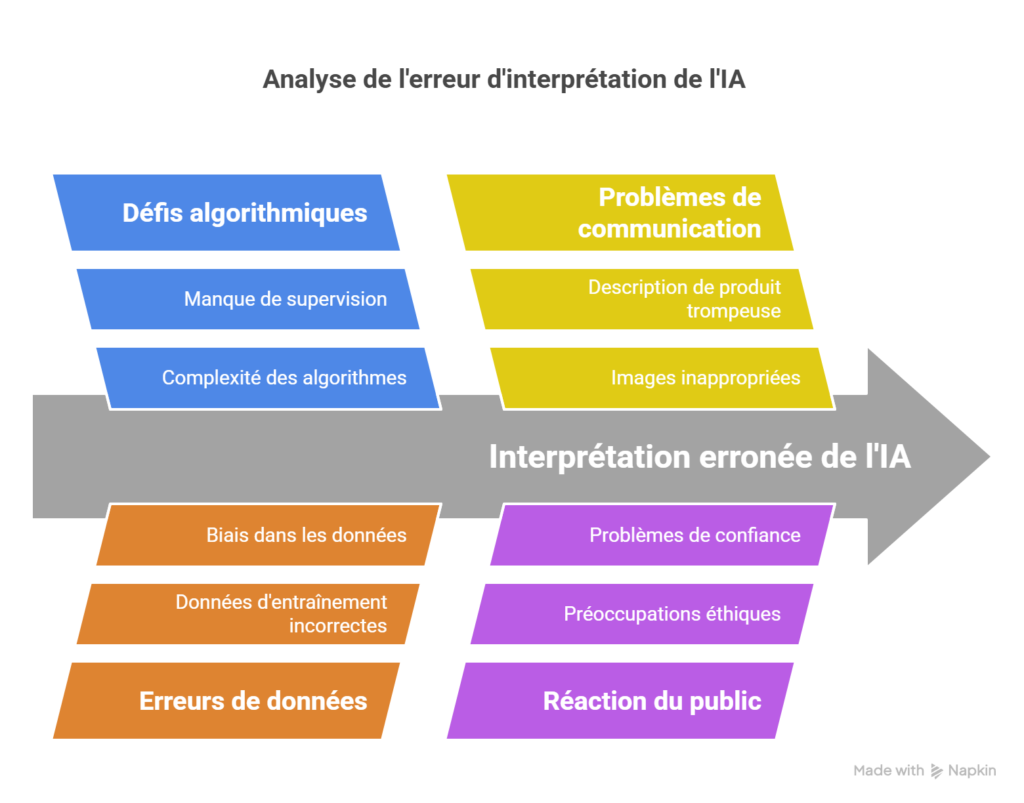

L’erreur provient d’une mauvaise interprétation d’un document officiel. Ce dernier, publié par le ministère de la Santé du New Hampshire, présentait une méthode appelée « baguette magique », visant à aider les parents à imaginer des solutions à des problèmes comportementaux. Cependant, l’IA a combiné cette terminologie avec des données sur le vibromasseur Hitachi Magic Wand, aboutissant à un résumé pour le moins inapproprié.

Les détails d’une aberration technologique

Une interprétation érronée qui choque la communauté

Selon l’IA, le sextoy était présenté comme un outil permettant de détecter des « changements de comportement » chez les enfants. Une image du produit accompagnait même l’aperçu de la recherche, tandis que le résumé mentionnait des usages fictifs dénués de sens. Les internautes n’ont pas tardé à réagir, qualifiant cet incident de « problème grave » et d’« aberration technologique ».

Malheureusement, ce n’est pas la première fois que l’IA de Google est au centre d’une controverse. Par le passé, elle avait été critiquée pour des suggestions absurdes, telles que conseiller de manger des cailloux ou d’ajouter de la colle à une pizza. Ces erreurs soulignent l’incapacité récurrente des systèmes d’IA à contextualiser correctement les informations.

Des dysfonctionnements symptomatiques de la course à l’IA

Pourquoi de telles erreurs persistent-elles ? La compétition intense entre les géants technologiques semble être en cause. Confrontée à des rivaux comme OpenAI et Microsoft, Google cherche à s’imposer comme leader de la recherche par IA. Cette précipitation se fait cependant au détriment de la qualité et de la fiabilité des résultats.

Le traitement des informations par l’IA repose sur des algorithmes complexes et des bases de données gigantesques. Cependant, lorsque ces systèmes manquent de supervision humaine rigoureuse, ils peuvent produire des résultats aberrants. Cette situation met en évidence un problème de fond : l’éthique et la responsabilité dans le développement de l’intelligence artificielle.

La réponse insuffisante de Google

Une correction rapide mais un silence pesant

Après la révélation de cette erreur, Google a rapidement supprimé le résumé erroné. Désormais, la recherche concernée affiche un message indiquant qu’un aperçu IA n’est pas disponible. Cependant, aucune explication détaillée ni excuse publique n’ont été formulées par l’entreprise. Cette absence de communication renforce les doutes des utilisateurs quant à la fiabilité des outils d’IA.

Les questions soulevées par cet incident

Cet événement pose des questions cruciales sur l’avenir de l’intelligence artificielle. Peut-on vraiment faire confiance à ces technologies pour traiter des sujets sensibles ? Les systèmes d’IA, censés améliorer la recherche en ligne, risquent de compromettre la précision des informations. De plus, leur impact écologique – en raison des ressources considérables nécessaires pour les faire fonctionner – suscite également des interrogations.

Comment éviter de nouveaux dérapages ?

La responsabilité des géants technologiques

Pour regagner la confiance des utilisateurs, Google et ses concurrents doivent garantir des outils fiables et éthiques. Cela implique de renforcer la supervision humaine dans le traitement des informations et d’éviter de lancer des fonctionnalités non abouties sous la pression du marché.

L’importance d’une IA contextuelle

Une IA capable de comprendre les subtilités culturelles et linguistiques est essentielle. Cela passe par l’amélioration des modèles d’apprentissage et une collaboration accrue entre chercheurs, développeurs et éthiciens.

Conclusion : un rappel à la vigilance

Cet incident avec l’IA de Google met en lumière les défis majeurs liés à l’intelligence artificielle. Si ces technologies ont un potentiel immense, leur utilisation doit être encadrée par des principes éthiques solides. Les utilisateurs attendent des solutions concrètes pour éviter que de tels dérapages ne se reproduisent.

En attendant, la vigilance reste de mise face à des outils qui, mal encadrés, peuvent engendrer des conséquences imprévisibles et parfois absurdes.

Share this content:

Laisser un commentaire