Intelligence Artificielle et Sexisme : Comment les IA Perpétuent les Stéréotypes de Genre ?

L’intelligence artificielle (IA) est omniprésente dans notre quotidien. Des assistants vocaux aux algorithmes de recommandation, en passant par les outils de génération d’images, elle influence de nombreux aspects de nos vies. Pourtant, loin d’être neutres, ces technologies reproduisent les biais sociétaux, notamment les préjugés sexistes.

L’IA et les stéréotypes de genre dans la génération d’images

Les IA génératives d’images comme Stable Diffusion ou DALL-E sont souvent pointées du doigt pour leur tendance à perpétuer des clichés de genre. Par exemple, lorsqu’on leur soumet des requêtes neutres telles que :

- « Une personne dirigeant une entreprise »

- « Un grand restaurant »

- « Un professionnel de la médecine »

Les résultats sont souvent les mêmes : des hommes blancs en position de pouvoir. À l’inverse, des requêtes telles que :

- « Un infirmier »

- « Une aide-ménagère »

- « Un aide à domicile »

Génèrent systématiquement des images de femmes. Cette tendance met en évidence la manière dont les algorithmes reproduisent inconsciemment les réalités sociétales et culturelles existantes.

L’impact des préjugés dans les textes générés par l’IA

Les préjugés sexistes ne se limitent pas aux images. Une étude récente de l’UNESCO a mis en évidence des biais similaires dans les textes produits par l’IA. Les chercheurs ont demandé à des plateformes d’IA générative de rédiger des histoires avec des personnages de genres, sexualités et origines variés. Les résultats ont révélé que les femmes et les minorités étaient souvent cantonnées à des rôles stéréotypés et à des descriptions plus limitées.

L’UNESCO a notamment relevé que :

- Les hommes étaient plus souvent décrits dans des professions valorisantes (enseignant, médecin, chauffeur).

- Les femmes étaient surreprésentées dans des rôles sous-estimés (domestique, cuisinière, prostituée).

- Les noms féminins étaient fréquemment associés à « maison », « famille », « enfants », tandis que les noms masculins étaient liés à « carrière », « salaire », « commerce ».

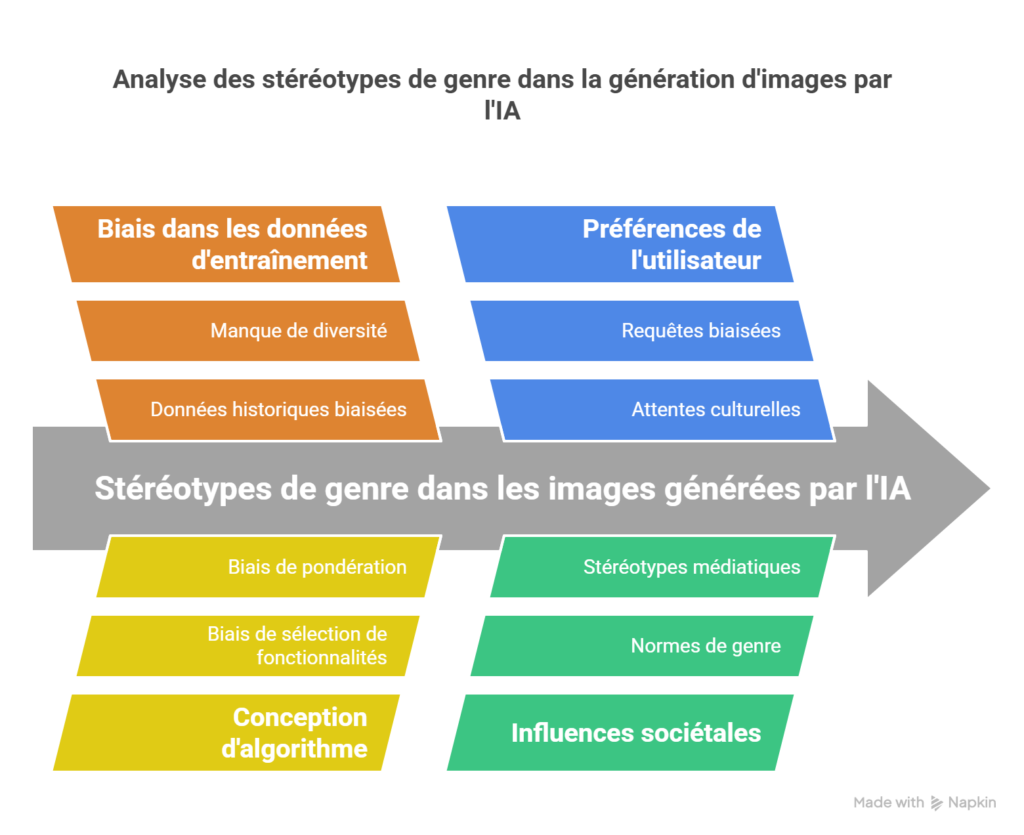

Pourquoi les IA sont-elles biaisées ?

Les IA ne créent pas ces biais de toutes pièces, elles les apprennent à partir des données sur lesquelles elles sont entraînées. Ces bases de données sont souvent constituées d’informations collectées sur Internet, un espace où les préjugés sociétaux sont omniprésents. Les algorithmes de machine learning absorbent ces tendances et les reproduisent de manière systématique.

Des biais inconscients des développeurs

Les équipes de développement elles-mêmes ne sont pas à l’abri de biais inconscients. Si la majorité des programmeurs sont des hommes blancs, leur perception du monde peut influencer la manière dont les modèles sont conçus et entraînés.

Comment lutter contre les biais sexistes de l’IA ?

Pour rendre l’intelligence artificielle plus inclusive, plusieurs actions peuvent être mises en place :

1. Améliorer la diversité des bases de données

Il est essentiel d’intégrer des données plus variées et représentatives de la diversité humaine afin de limiter la perpétuation des stéréotypes.

2. Mettre en place des filtres et correctifs algorithmiques

Des algorithmes de correction peuvent être développés pour détecter et corriger les biais en temps réel.

3. Favoriser la transparence et l’éthique dans l’IA

Les entreprises développant ces technologies doivent être plus transparentes quant à la manière dont leurs modèles sont entraînés et les méthodes employées pour limiter les biais.

4. Sensibiliser les développeurs et utilisateurs

Les professionnels de l’IA doivent être formés aux enjeux éthiques et aux biais afin d’adopter une approche plus inclusive dans la création des modèles.

Conclusion

L’intelligence artificielle reflète les préjugés de notre société. Son influence grandissante impose une responsabilité aux développeurs et aux entreprises pour créer des modèles plus équitables. Sensibilisation, diversification des bases de données et mise en place de filtres correctifs sont autant de solutions pour réduire les biais sexistes et favoriser une IA plus inclusive. La technologie doit être un outil d’égalité, et non un vecteur de discrimination.

Share this content:

Laisser un commentaire