Gemini 1.5 Pro : La plus grande erreur que tout le monde commet (et comment l’éviter)

Introduction : La promesse et le paradoxe

Gemini 1.5 Pro représente une avancée technologique révolutionnaire, redéfinissant les limites de l’intelligence artificielle. Sa capacité la plus spectaculaire est sa fenêtre de contexte massive d’un million de tokens, lui permettant de traiter des volumes de données autrefois inimaginables en une seule fois : 11 heures d’audio, une heure de vidéo, 700 000 mots de texte ou plus de 30 000 lignes de code. C’est une prouesse qui promet de transformer notre interaction avec l’information.

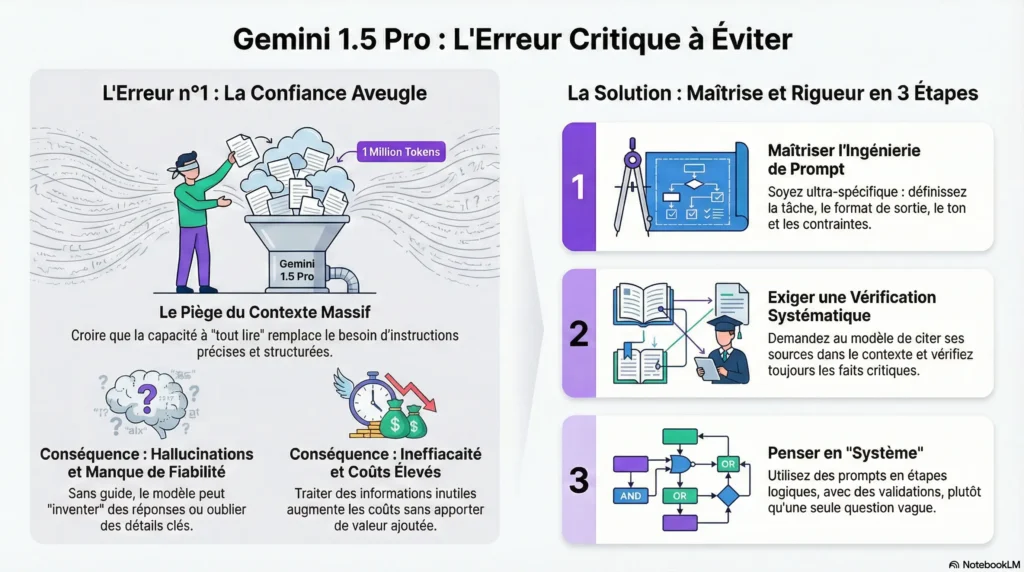

Pourtant, c’est précisément cette force incroyable qui est à l’origine de l’erreur la plus critique que commettent les utilisateurs, une erreur qui les empêche de libérer le véritable potentiel du modèle. Ce piège commun naît d’une « confiance aveugle » dans ses capacités brutes, menant à des résultats décevants et coûteux.

Cet article vous révélera les leçons les plus surprenantes sur l’utilisation efficace de Gemini 1.5 Pro. L’objectif est de transformer votre approche, vous faisant passer du statut de simple utilisateur à celui de maître-opérateur capable d’exploiter cette puissance avec précision et fiabilité.

——————————————————————————–

Les 4 leçons contre-intuitives sur Gemini 1.5 Pro

Leçon 1 : Sa plus grande force est un piège

L’erreur numéro un est une confiance aveugle dans sa fenêtre de contexte massive, couplée à une ingénierie de prompt négligée, et l’omission d’une vérification rigoureuse des sorties. De nombreux utilisateurs, éblouis par la capacité du modèle à « tout retenir », pensent qu’il suffit de lui fournir une quantité gargantuesque de données pour obtenir des réponses parfaites. C’est une approche vouée à l’échec. La capacité à traiter une information ne garantit pas la capacité à raisonner parfaitement dessus sans une direction claire.

Cette erreur est critique car elle mène à des sorties de moins bonne qualité, souvent génériques ou non pertinentes. Sans instructions spécifiques pour naviguer dans le vaste contexte fourni, le modèle manque de la guidance nécessaire pour comprendre vos intentions profondes et fournir une analyse précise.

Leçon 2 : Une mémoire d’un million de tokens n’est pas infaillible

Une autre découverte surprenante est que la mémoire massive de Gemini 1.5 Pro a ses limites. Bien qu’il puisse retrouver une information précise dans une masse de données avec une précision de 99 %, ce n’est pas 100 %. Des utilisateurs ont rapporté que le modèle peut encore « oublier » des détails critiques, en particulier lorsque ces informations sont enfouies au milieu d’un contexte très large (au-delà de 500 000 tokens).

Le fait que Gemini 1.5 Pro puisse traiter un million de tokens ne signifie pas qu’il va toujours raisonner parfaitement sur toutes les informations, ni qu’il sera capable de déduire vos intentions sans des instructions claires et structurées.

Cette prise de conscience est cruciale. Elle brise le mythe d’un « rappel total » parfait et renforce la nécessité absolue de structurer les prompts pour aider le modèle à se concentrer sur les éléments importants. Ce 1 % d’incertitude potentielle souligne que la vérification des résultats n’est pas une option, mais une obligation.

Leçon 3 : Sans discipline, sa puissance devient coûteuse

L’utilisation de Gemini 1.5 Pro a des implications financières directes. Sa tarification est basée sur le nombre total de tokens traités, à la fois en entrée et en sortie. Injecter le maximum de contexte sans une stratégie claire — en incluant des informations non pertinentes ou en formulant des demandes vagues — peut faire grimper les coûts de manière exponentielle, d’autant que la tarification peut différer pour les prompts dépassant les 128 000 tokens.

L’optimisation des prompts n’est donc pas seulement une question de qualité des résultats ; c’est une stratégie fondamentale pour l’efficacité financière. Minimiser l’utilisation de tokens en étant précis et en tirant parti de fonctionnalités comme la mise en cache du contexte (« context caching ») pour les tâches répétitives est essentiel pour obtenir un retour sur investissement positif de cet outil puissant.

Leçon 4 : Devenez un architecte du contexte, pas un simple utilisateur

Pour véritablement maîtriser Gemini 1.5 Pro, il faut adopter un nouvel état d’esprit : celui d’un architecte du contexte. Adopter cet état d’esprit exige une discipline rigoureuse, articulée autour de trois piliers d’action :

- Maîtriser l’ingénierie de prompt structurée : Allez au-delà des questions simples. Utilisez des techniques avancées comme définir un rôle (« Agis comme un analyste financier senior »), employer le « Chain-of-Thought » pour décomposer les problèmes, et fournir des exemples via le « Few-Shot Learning ». Par exemple, au lieu de « Résume ce document », demandez : « Résume ce rapport financier de 200 pages pour un investisseur non expert en 500 mots, en mettant l’accent sur les risques et les opportunités, et présente-le sous forme de points à puces. »

- Pratiquer la vérification systématique : Ne faites jamais une confiance aveugle à la sortie. Intégrez dans vos prompts des commandes pour que le modèle cite ses sources ou vous oriente vers des sections spécifiques au sein du contexte fourni. Ajoutez des instructions comme « si tu n’es pas sûr, indique-le explicitement » pour l’empêcher d’inventer des réponses.

- Gérer le contexte intelligemment : Au lieu de soumettre un document de 1000 pages d’un seul coup pour une question complexe, demandez d’abord au modèle de résumer les sections pertinentes. Utilisez ensuite ces résumés comme un contexte plus ciblé pour vos questions de suivi.

Cette approche est ce qui sépare les utilisateurs occasionnels des experts qui transforment la puissance brute de Gemini 1.5 Pro en une intelligence fiable et à haute valeur ajoutée.

——————————————————————————–

Conclusion : Votre prochain prompt décidera de tout

Gemini 1.5 Pro est un bond en avant phénoménal, mais sa valeur ultime n’est pas débloquée par sa capacité brute, mais par la compétence de l’utilisateur. Pour maîtriser cet outil, il faut passer du rôle de simple « fournisseur de données » à celui d’un « architecte du contexte », qui sculpte, guide et vérifie chaque interaction.

La puissance brute de Gemini 1.5 Pro est à votre portée. Maintenant que vous en connaissez les pièges, comment allez-vous architecturer votre prochain prompt pour transformer cette puissance en une intelligence réellement fiable ?

Share this content:

Laisser un commentaire