Au-delà des GPU : Découvrez le futur cerveau de l’intelligence artificielle

L’intelligence artificielle moderne, et plus particulièrement les grands modèles de langage (LLM) qui alimentent les outils de nouvelle génération, a une faim dévorante.

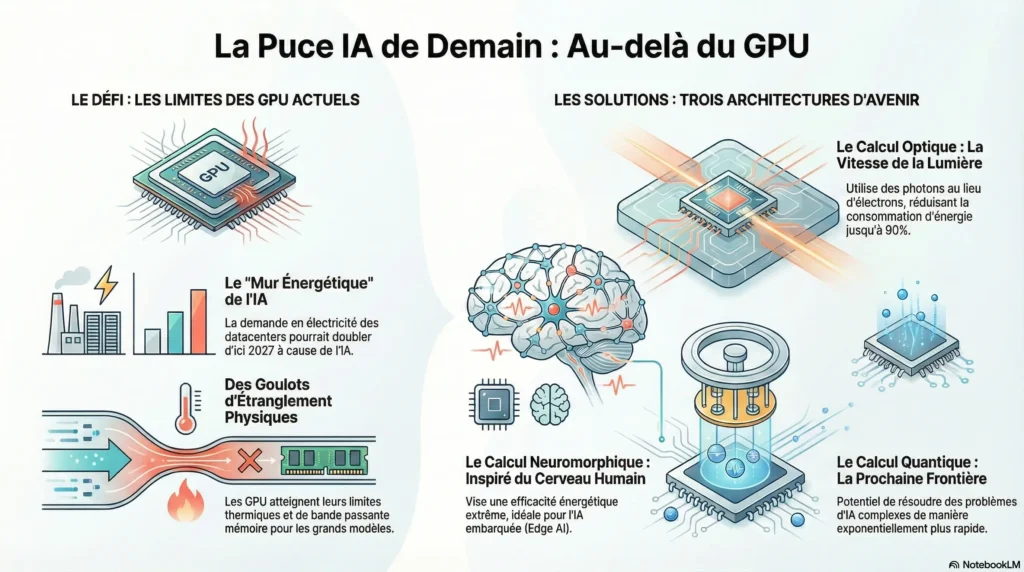

Cette faim n’est pas seulement pour les données, mais aussi pour l’énergie. Les processeurs graphiques (GPU), qui ont été pendant des années la solution de référence pour entraîner ces modèles, atteignent aujourd’hui leurs limites physiques. Ils consomment une quantité d’énergie colossale, créant un véritable « mur énergétique » : selon les prévisions, la demande en électricité des centres de données pourrait doubler d’ici 2027, en grande partie à cause de l’IA.

Cet article a pour but de lever le voile sur les architectures matérielles révolutionnaires et les tendances surprenantes qui se dessinent pour alimenter la prochaine génération d’IA. Nous allons explorer quatre des idées les plus contre-intuitives et impactantes qui promettent de redéfinir les fondations physiques de l’intelligence artificielle, bien au-delà des solutions que nous connaissons aujourd’hui.

Le vrai goulot d’étranglement de l’IA n’est pas la puissance de calcul

Contrairement à une idée reçue, le plus grand défi pour le matériel IA n’est plus la vitesse de calcul brute. Le véritable facteur limitant est devenu le déplacement et le stockage des données. Chaque fois qu’une information doit être déplacée entre la mémoire et le processeur, cela consomme du temps et, surtout, une quantité d’énergie disproportionnée. Les futures architectures matérielles sont donc conçues avec un objectif prioritaire : minimiser ce mouvement de données pour débloquer de nouveaux niveaux de performance et d’efficacité. C’est précisément pour s’attaquer à ce goulot d’étranglement que les architectures photoniques et neuromorphiques réinventent la manière dont l’information est traitée, en la rapprochant au plus près du calcul.

Demain, l’IA fonctionnera à la vitesse de la lumière

Le calcul optique, ou photonique, est une approche qui remplace l’électricité (les électrons) par la lumière (les photons) pour traiter l’information. Concrètement, ces puces utilisent des circuits photoniques pour exécuter quasi-instantanément les « multiplications matricielles », l’opération mathématique au cœur de tous les réseaux neuronaux modernes, ce qui explique leur efficacité redoutable. Ses avantages sont spectaculaires : une vitesse de traitement extrême (littéralement à la vitesse de la lumière), une réduction drastique de la consommation d’énergie pouvant atteindre 90 %, et une génération de chaleur quasi nulle. En surmontant les limites de la loi de Moore, le calcul photonique pourrait devenir le moteur des IA de demain. Bien que des défis subsistent en matière d’intégration et de coût, cette technologie est extrêmement prometteuse pour accélérer les IA génératives et le calcul haute performance.

Les futures puces imiteront le cerveau humain

Une autre approche révolutionnaire est le calcul neuromorphique, qui s’inspire directement du fonctionnement du cerveau humain pour concevoir des puces radicalement différentes. L’objectif est de reproduire l’efficacité énergétique stupéfiante de notre propre cerveau. La comparaison est frappante : le cerveau humain consomme environ 20 watts pour fonctionner, tandis que les systèmes GPU actuels en nécessitent des milliers. Le secret de ces puces réside dans leur fonctionnement : elles fonctionnent sur la base de « réseaux de neurones à impulsions » (Spiking Neural Networks), ne s’activant qu’en réponse à de nouvelles informations, tout comme les neurones, ce qui élimine le gaspillage d’énergie. Un exemple concret est le processeur Loihi d’Intel, déjà utilisé dans des applications d’IA embarquée comme les véhicules autonomes ou les capteurs intelligents, où une consommation d’énergie ultra-faible est primordiale.

L’IA a commencé à concevoir ses propres puces

L’une des tendances les plus surprenantes est peut-être celle-ci : l’intelligence artificielle est désormais utilisée pour créer son propre matériel. L’IA générative conçoit des circuits et des systèmes matériels complets, surpassant souvent les ingénieurs humains en vitesse et en créativité pour trouver des solutions optimisées. Ce phénomène crée une boucle de rétroaction positive fulgurante : une IA plus performante conçoit du matériel plus efficace, qui à son tour permet de développer une IA encore plus puissante. Ce cycle réduit considérablement les coûts et les délais de conception, accélérant l’innovation à un rythme sans précédent.

Conclusion : Une nouvelle ère pour le « cerveau » de l’IA

Le futur du matériel IA ne réside pas dans une solution unique et toute-puissante. La « puce de demain » sera en réalité un écosystème diversifié où des architectures spécialisées, optiques, neuromorphiques et, à terme, quantiques, travailleront en synergie pour répondre aux besoins toujours croissants de l’intelligence artificielle. Ces nouvelles approches ne sont pas de simples améliorations ; elles représentent une réinvention fondamentale du substrat physique de l’IA.

Alors que nous nous concentrons sur les progrès fulgurants des logiciels d’IA, la véritable révolution ne se déroule-t-elle pas silencieusement dans son cerveau physique ?

Share this content:

Laisser un commentaire