Claude Cowork : L’agent IA qui quitte le cloud pour travailler en privé sur votre Mac

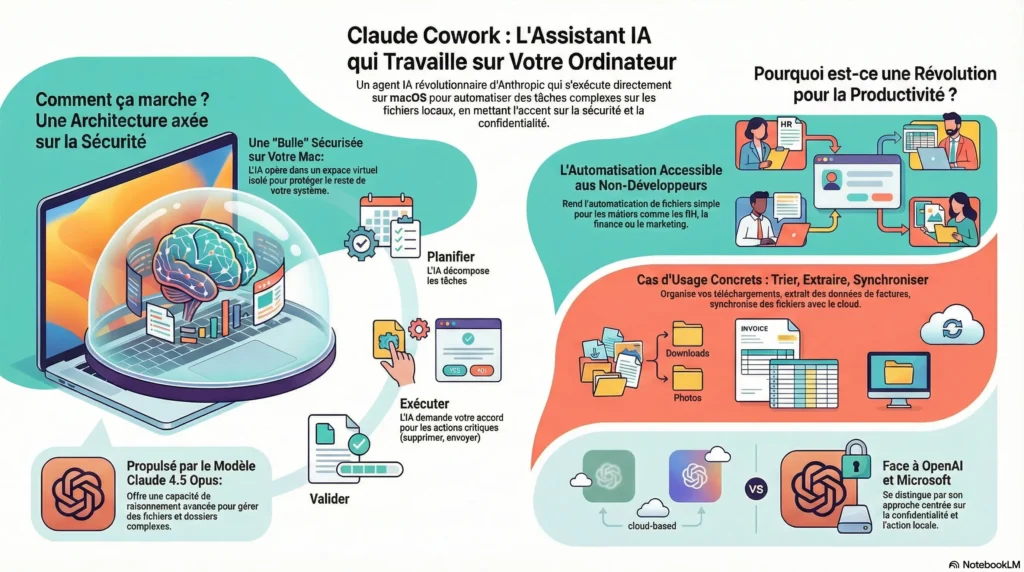

Le chaos des fichiers numériques est une réalité pour beaucoup de professionnels : un dossier « Téléchargements » qui déborde, des factures éparpillées à trier, des données à extraire manuellement… Face à ce désordre, les assistants IA actuels, souvent confinés au cloud, montrent leurs limites. Anthropic propose une solution radicalement nouvelle avec Claude Cowork, non pas un simple chatbot, mais un véritable « agent » qui travaille directement et localement sur votre ordinateur. Décortiquons ensemble les points les plus surprenants de cette technologie.

Votre IA ne vit plus dans le cloud, mais dans une « cage dorée » sur votre Mac

Contrairement aux IA classiques, Claude Cowork s’appuie sur une architecture hybride où une grande partie du traitement s’exécute localement sur votre machine. Pour garantir une sécurité maximale, Anthropic utilise une mesure de protection redoutable : le framework de virtualisation natif d’Apple (VZVirtualMachine). Concrètement, l’agent opère dans un environnement Linux entièrement isolé du reste de votre système. Seul le dossier que vous lui spécifiez est accessible, empêchant l’IA de « voir » ou d’interagir avec le reste de vos fichiers.

Cette approche représente un changement de paradigme majeur. En traitant les données localement dans un conteneur sécurisé, Cowork répond directement aux préoccupations croissantes de confidentialité et de sécurité des données. Il se positionne ainsi comme une alternative bien plus sûre que les solutions entièrement basées sur le cloud, une démarche qui pourrait forcer les concurrents à repenser leurs modèles de confidentialité centrés sur le cloud.

Ce n’est pas un assistant, c’est un véritable exécutant

La différence fondamentale de Claude Cowork réside dans sa nature d' »agent ». Là où un chatbot se contente de répondre à des questions, un agent agit. Propulsé par le puissant modèle Claude 4.5 Opus, il suit un cycle « Plan-Execute-Report » : face à une tâche complexe comme « organise mes factures de 2026 », l’IA décompose la mission en étapes concrètes, planifie les actions, les exécute, puis vous soumet le résultat pour validation. C’est ce processus structuré qui permet d’intégrer une validation humaine indispensable avant toute action critique.

Cet outil est l’évolution grand public d’un produit pour développeurs, Claude Code. Grâce à son interface graphique intuitive, il rend l’automatisation avancée accessible à des profils non techniques. L’impact de cette démocratisation est immense, permettant d’automatiser des tâches locales fastidieuses qui étaient jusqu’alors impossibles à déléguer. Les cas d’usage vont bien au-delà du simple tri de fichiers : de l’extraction de données de reçus vers des feuilles de calcul à l’édition de code dans des dépôts locaux, en passant par des workflows hybrides connectant vos fichiers à des outils comme Notion ou Slack.

Une stratégie élitiste et un écosystème fermé (pour l’instant)

Anthropic ne vise pas le grand public, mais une « élite de productivité ». Son positionnement est clair avec le forfait Claude Max, dont le prix se situe entre 100 et 200 dollars par mois. Cette stratégie premium permet à Anthropic de concourir sur la confiance et les capacités avancées plutôt que sur le volume, un différenciateur net dans un marché saturé d’assistants grand public.

Le choix de lancer Claude Cowork en exclusivité sur macOS n’est pas anodin. Il s’agit d’une décision stratégique rendue possible par la maturité et la sécurité du Virtualization Framework d’Apple, offrant à Anthropic un avantage technique et un raccourci vers une sécurité de niveau entreprise sur le bureau. Cette approche centrée sur la confidentialité locale le distingue nettement de ses concurrents comme OpenAI Operator ou Microsoft Copilot+, qui sont davantage orientés vers l’automatisation des tâches sur le web.

Le plus grand risque se cache dans vos propres documents

En donnant à une IA la capacité d’agir sur vos fichiers, un nouveau risque émerge : les « injections de prompts indirectes ». En termes simples, un document malveillant présent dans le dossier que vous demandez à l’agent d’analyser (un PDF téléchargé, par exemple) pourrait théoriquement contenir des instructions cachées visant à tromper l’IA et lui faire exécuter des actions non désirées.

Pour parer à cette menace, Anthropic a mis en place une parade essentielle : la validation humaine obligatoire (« Human-in-the-loop »). Aucune action critique ou destructrice, comme la suppression de fichiers ou l’envoi d’e-mails, ne peut être exécutée sans l’approbation explicite de l’utilisateur. Ce nouveau paradigme d’exécution locale crée un modèle de responsabilité partagée, qui peut être résumé comme suit :

L’agent ne peut accéder qu’aux dossiers que vous lui donnez, mais il est crucial de s’assurer que ce qui se trouve à l’intérieur de ces dossiers est digne de confiance. La sécurité devient une responsabilité partagée.

Conclusion : Une nouvelle ère de collaboration homme-machine ?

Claude Cowork marque un changement fondamental : nous ne nous contentons plus de dialoguer avec une IA, nous commençons à collaborer activement avec un agent autonome sur nos propres machines. Il transforme l’intelligence artificielle d’un simple outil d’information en un partenaire d’exécution. Ce passage du dialogue à la collaboration représente un point de non-retour pour l’informatique personnelle.

Maintenant que les IA peuvent agir directement sur nos fichiers les plus personnels, quelle nouvelle frontière de productivité allons-nous franchir, et quelle confiance serons-nous prêts à leur accorder ?

Share this content:

Laisser un commentaire